E047_Orquestando_agentes_complejos_con_LangGraph

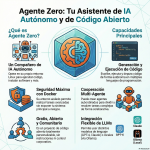

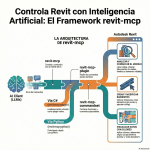

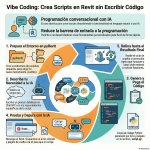

LangGraph: La Evolución de la Inteligencia Artificial LangGraph es una herramienta revolucionaria que permite a los desarrolladores crear aplicaciones de inteligencia artificial complejas y fiables. A diferencia de su predecesor Landchain, que se enfoca en flujos de trabajo lineales, LangGraph se centra en la creación de mapas de decisiones con bucles, bifurcaciones y saltos condicionales. Esto permite a los agentes de IA “pensar” de manera más humana, tomando decisiones y corrigiendo errores de forma autónoma. Con características como la memoria a corto y largo plazo, la gestión de estado y la intervención humana, LangGraph ofrece una solución robusta para aplicaciones críticas. Aunque puede ser complejo de implementar, su capacidad para gestionar sistemas cíclicos y aprender de las interacciones lo convierte en un cambio de paradigma en el campo de la inteligencia artificial.