Buenas, esto es BIMPRAXIS, el podcast donde el BIM se encuentra con la inteligencia artificial.

Exploramos la ciencia, la tecnología y el futuro desde el enfoque de la arquitectura, ingeniería y construcción.

¡Empezamos!

Hola y bienvenidos. Hoy retomamos nuestra serie especial para BIMPRAXIS, los papers que cambiaron la historia de la IA.

Y este es el análisis número 17.

Y creo que el de hoy encaja perfectamente en esa descripción.

Nos sumergimos en un artículo que, aunque es muy reciente, no se limita a presentar un avance,

sino que se atreve a desafiar la dirección en la que parece moverse todo el campo.

Totalmente. Tenemos sobre la mesa un paper de Archive, la gran plataforma de prepublicación científica.

Y el título ya es todo una declaración de intenciones.

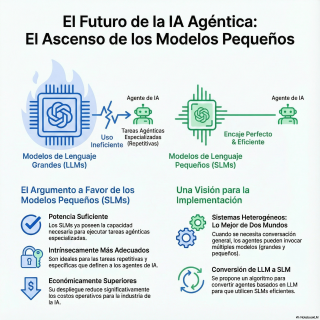

Small Language Models are the Future of Agentic AI.

O en español.

Los modelos de lenguaje pequeños son el futuro de la IA.

Es un título que te obliga a leerlo dos veces, porque choca frontalmente con la narrativa que llevamos, vamos, años escuchando.

Claro, la idea de que el progreso en IA es sinónimo de escala.

Más parámetros, más datos de entrenamiento, modelos cada vez más y más grandes.

Exacto. Hemos estado inmersos en una especie de carrera armamentística por el tamaño.

Y de repente llega este equipo liderado por Peter Belzac y dice…

Un momento. ¿Y si hemos estado mirando en la dirección equivocada?

¿Y si el futuro no es más grande, sino más astuto y especializado?

Justo.

Y es clave entender cómo lo presentan. El propio documento lo califica de declaración de valor.

No es un simple experimento con una tabla de resultados.

Es una tesis, un argumento casi filosófico sobre eficiencia y sostenibilidad.

Publicado en junio de 2025 y revisado en septiembre.

Así que estamos…

Estamos analizando el pensamiento más vanguardista.

Pues vamos a desgranar esa tesis. Por lo que veo, no empiezan atacando directamente.

De hecho, el resumen reconoce el mérito de los grandes modelos de lenguaje, los LLMS.

Correcto. No es una refutación. Es una recontextualización.

Parten de un respeto por lo que se ha conseguido.

Los LLMS son una maravilla, capaces de una flexibilidad casi humana.

Pero justo después introducen el concepto que lo cambia todo.

Los sistemas agénticos.

Y esta definición es el corazón de su argumento.

Totalmente.

¿Y cómo los definen exactamente?

Porque agente es una de esas palabras que se usan para todo en este sector.

Pues el paper es muy preciso aquí.

Los define como aplicaciones donde los modelos de lenguaje realizan un número reducido de tareas especializadas de forma repetitiva y con poca variación.

O sea, no hablamos de un chat filosófico.

Para nada. Estamos hablando de la IA que trabaja en segundo plano.

Entendido. Entonces, ¿no es un tema de la IA que trabaja en segundo plano?

Entonces, ¿no es un tema de la IA que trabaja en segundo plano?

Entonces, ¿no es un tema de la IA que trabaja en segundo plano?

No hablamos de pedirle un chatbot que nos escriba un poema,

sino de un sistema que, por ejemplo, procesa miles de facturas al día para extraer datos concretos.

Exactamente esos casos.

O un agente que monitoriza redes sociales para clasificar menciones de un producto.

Es la IA como una herramienta industrial, no como un compañero de conversación.

Y es en ese contexto donde lanzan su idea principal.

Para estas tareas, los modelos pequeños, los SLMs, son una opción superior.

Y lo basan en tres pilares.

Suficientemente potentes, inherentemente más adecuados y, por supuesto, necesariamente más económicos.

A ver, el tercer punto, el del coste, parece el más obvio.

Pero los dos primeros son más atrevidos.

¿De verdad un modelo pequeño es suficientemente potente?

Esa es la primera gran afirmación que hacen.

Sostienen que los SLMs ya han cruzado un umbral de calidad

que les permite ejecutar estas tareas concretas con una eficacia aleatoria.

Esa es la primera gran afirmación que hacen.

La complejidad de un modelo gigante, que sabe de física cuántica y de la dinastía Ming,

es un desperdicio absoluto para leer una factura.

Suena al viejo dicho de no usar un mazo para cascar una nuez.

Pero es solo una cuestión de desperdicio.

Ahí es donde entra el segundo pilar.

Inherentemente más adecuados.

Y no es solo que el mazo sea excesivo.

Es que el mazo puede romper la mesa, la nuez y hasta los dedos.

Entiendo.

Un LLM.

Por su propia naturaleza expansiva, es más propenso a alucinar,

a inventarse un dato o a salirse del guión.

Interesante.

O sea que para una tarea que exige precisión y fiabilidad,

como extraer datos financieros,

la creatividad de un LLM se puede convertir en un riesgo.

Precisamente.

Un SLM, entrenado específicamente para esa tarea,

es como un cirujano con un bisturí.

Su dominio restringido es una ventaja, no una limitación.

Es más rápido.

Más predecible y, en última instancia, más seguro.

Vale.

Esos dos puntos dibujan un cuadro muy convincente a nivel técnico.

Pero volvamos al tercer pilar, necesariamente más económicos.

Porque creo que aquí es donde el argumento pasa de ser

una discusión académica a una revolución industrial.

Sin duda.

Y la escala de la diferencia es difícil de exagerar.

El coste de entrenar un LLM se cuenta en cientos de millones.

Pero el verdadero coste oculto,

está en la operación, en la inferencia.

Cada vez que le pides que haga algo.

Exacto.

Y esos costes pueden sumar millones al MIS para una empresa grande.

Entonces, si una empresa tiene un agente que procesa un millón de correos al día,

el coste de usar un LLM gigante para cada uno de esos correos es…

Astronómico.

Exacto.

Con un SLM optimizado, el coste por inferencia se desploma.

Puede ser cientos o miles de veces más barato.

Y esto tiene dos consecuencias enormes.

La primera, imagino,

es la democratización.

Desde luego.

Pequeños y medianas empresas podrían desplegar soluciones de IA que hoy son prohibitivas.

Y la segunda es el impacto energético.

La huella de carbono de estos sistemas es un tema cada vez más preocupante.

Un cambio masivo a SLMs sería un paso gigantesco hacia una IA más sostenible.

Sin duda.

Entiendo el argumento.

Es demoledor para esas tareas repetitivas.

Pero me queda una duda importante.

¿Qué es el cambio de LLM?

¿Qué es el cambio de LLM?

¿Qué es el cambio de LLM?

¿Qué es el cambio de LLM?

¿Qué es el cambio de LLM?

¿Qué es el cambio de LLM?

¿Qué es el cambio de LLM?

Si mi agente está clasificando facturas con un SLM y de repente se topa con una nota

extraña escrita a mano, ¿se queda bloqueado?

¿No hemos perdido justo esa flexibilidad que nos vendieron como la gran ventaja de

los LLMs?

Esa es la pregunta clave.

Y la respuesta que da el paper es, en mi opinión, la parte más elegante de toda la

propuesta.

¿Y cuál es?

No abogan por un mundo solo de SLMs.

Proponen lo que llaman sistemas agénticos heterogéneos.

¿Heterogéneos?

¿Heterogéneos?

O sea, una mezcla.

¿Quieren decir que un agente no tiene por qué usar un único cerebro?

Exacto.

La idea es brillante en su simplicidad.

Piensa en ello no como un único empleado que lo sabe todo, sino como un equipo de especialistas

gestionado por un jefe de proyecto.

Ah, vale.

Es como un capataz de obra que tiene una caja de herramientas.

Para el 90% de las tareas, los tornillos de siempre, usa una llave inglesa pequeña

y eficiente.

¿Un SLM?

Eso es.

Pero si de repente aparece un muro que hay que derribar, en lugar de darle golpecitos

con la llave, saca el teléfono y llama al martillo pilón, el LLM, solo para esa tarea

específica.

Esa analogía es perfecta.

El agente actúa como ese capataz, o como me gusta llamarlo a mí, un director de orquesta.

Me gusta.

La mayor parte del tiempo, la melodía la llevan los violines, los SLMs, que son ágiles.

Pero cuando la sinfonía lo requiere…

El director da la entrada a los timbales, el LLM, que interviene con toda su potencia.

Y luego vuelve al silencio.

Se trata de usar el recurso adecuado en el momento adecuado.

Justo.

Pero esto, que suena genial en teoría, me genera nuevas preguntas.

Ese director de orquesta, ¿quién es?

¿Cómo decide qué herramienta usar?

Porque esa decisión en sí misma parece un problema de IA bastante complejo.

Absolutamente.

Y ese es uno de los grandes desafíos técnicos que esta visión,

implica.

El sistema necesita un enrutador inteligente, una especie de meta-agente,

que analiza la tarea y decide si es para un SLM o requiere al LLM.

Y si se equivoca, el resultado puede ser o un fallo en la tarea o un coste disparado,

si por error envía miles de tareas simples al LLM.

La ventaja económica desaparece, claro.

La implementación de este director es crucial.

El paper no entra en los detalles, pero reconoce que la orquestación de estos sistemas,

es el siguiente gran reto.

La habilidad del futuro quizá no sea tanto el prompt engineering, sino la arquitectura de sistemas.

La visión es muy convincente, pero parece una auténtica revolución.

Y las revoluciones siempre encuentran resistencia.

Me imagino que el paper debe abordar las barreras para que esta idea se adopte, ¿no?

Sí, sí, lo mencioné explícitamente.

Y aunque el resumen no las detalla, podemos especular sobre ellas.

A ver, yo veo una barrera económica obvia.

Las grandes tecnológicas han invertido miles de millones,

en la infraestructura para LLMs gigantes.

¿Cambiar el rumbo de ese transatlántico?

No es trivial. Esa es la inercia del mercado.

Y es una fuerza poderosísima.

Tienen un foso económico construido alrededor de los LLMs.

¿Qué incentivo real tienen para canibalizar su propio producto estrella?

Bueno, también se podría argumentar que son las únicas con los recursos

para construir y ofrecer estos ecosistemas heterogéneos de forma eficaz.

Podría ser su siguiente gran línea de negocio.

Y luego está el factor humano.

¿Qué es el factor humano?

¿Qué es el factor humano?

¿Qué es el factor humano?

¿Qué es el factor humano?

¿Qué es el factor humano?

¿Qué es el factor humano?

¿Qué es el factor humano?

Si eres desarrollador, te han dicho durante años

que tienes que usar lo último y lo más grande.

Hay un factor de prestigio.

Es más sexy decir que tu app usa el último gran modelo.

Totalmente. Es una barrera cultural.

Hay que reeducar a una generación de ingenieros

que ha crecido con el mantra de más grande es mejor.

Hay que demostrar que usar un modelo más pequeño no es un paso atrás,

sino una decisión de ingeniería más inteligente.

Entonces, tenemos barreras económicas, culturales

y los desafíos técnicos que mencionamos.

¿El paper se queda solo en señalar la dirección

o propone alguna ayuda para empezar el camino?

Aquí es donde demuestran que su intención es práctica.

Proponen un Algoritmo General de Conversión de Agente de LLM a SLM.

Ah, eso es crucial.

No solo dicen, este es el futuro, sino que añaden,

y aquí tenéis una receta, una hoja de ruta

para empezar a convertir vuestros sistemas.

Eso lo cambia todo.

Es pasar de la visión a la herramienta.

¿Qué es el factor humano?

¿Qué es el factor humano?

¿Qué es el factor humano?

¿Qué es el factor humano?

¿Qué es el factor humano?

¿Qué es el factor humano?

¿Qué es el factor humano?

¿Qué es el factor humano?

¿Qué es el factor humano?

Esto conecta con algo que me llamó la atención del resumen,

su compromiso con el debate público.

Sí, y es algo bastante inusual y, en mi opinión, muy admirable.

Se comprometen a publicar toda la correspondencia relacionada con el paper,

tanto las contribuciones que apoyan su tesis como las críticas,

en una URL pública.

Es un gesto de transparencia admirable, casi radical,

pero, siendo un poco cínico,

¿podría ser una maniobra para controlar la narrativa?

Suena un poco idealista.

Es una lectura posible.

Pero yo tiendo a verlo de otra forma.

Creo que refleja que son conscientes de la magnitud de lo que proponen.

Es una llamada abierta a la comunidad.

Como un, aquí está nuestra tesis, por favor, atacadla, mejoradla,

pero tengamos esta conversación en abierto.

Exacto.

Porque definirá la economía, la sostenibilidad y la accesibilidad de la IA en la próxima década.

Visto así, tiene todo el sentido.

Si juntamos todas las piezas, el panorama que dibuja este paper es fascinante.

Quizás el futuro de la IA en nuestro diálogo,

quizás el futuro de la IA en nuestro diálogo,

no sea un único asistente omnipotente como en las películas.

Sino más bien una red invisible de pequeños especialistas eficientes.

Un ejército de agentes silenciosos.

Exacto.

Cada uno haciendo una cosa muy bien y de forma muy barata.

El artículo nos obliga a cambiar la pregunta fundamental.

Durante años la pregunta ha sido, ¿cómo hacemos los modelos más grandes?

TIL, ¿cuál es el modelo del tamaño adecuado para esta tarea concreta?

Es un cambio de paradigma total.

Pasar de la fuerza bruta a la elegancia.

De la escala a la eficiencia.

Y a la sostenibilidad.

Es una visión de la IA mucho más madura, más pragmática.

Y con esto, como siempre, dejamos una reflexión final.

Si esta visión es correcta, si el futuro son estos pequeños agentes,

pensemos por un momento en nuestras propias rutinas.

Que tareas repetitivas de nuestro trabajo,

esas que hacemos casi sin pensar,

podrían ser las primeras en ser gestionadas por este ejército invisible.

No por un gran asistente.

No por un gran asistente al que le damos órdenes.

Sino por decenas de pequeños optimizadores que, sin que apenas nos demos cuenta,

van puliendo las fricciones de nuestro día a día.

Una idea muy potente.

Mañana volveremos con otro análisis y les aseguro que el paper que tenemos preparado

es de los que realmente hacen pensar en las fronteras de la inteligencia artificial,

en la naturaleza misma de la conciencia y la creatividad.

No se lo pierdan.

Y hasta aquí el episodio de hoy.

Muchas gracias por tu atención.

Esto es BIMPRAXIS.

Nos escuchamos en el próximo episodio.