Buenas, esto es BIMPRAXIS, el podcast donde el BIM se encuentra con la inteligencia artificial.

Exploramos la ciencia, la tecnología y el futuro desde el enfoque de la arquitectura, ingeniería y construcción.

¡Empezamos!

Hola y bienvenidos. Hoy nos sumergimos en la decimosexta entrega de nuestra serie especial en BIMPRAXIS,

los papers que cambiaron la historia de la IA. Pero, el documento que tenemos hoy sobre la mesa tiene algo peculiar.

No es el típico artículo académico que uno esperaría.

Sí, es una puntualización importante. Nuestra fuente principal es un informe que OpenIP publicó en su blog el 12 de septiembre de 2024.

Y aunque no es un paper revisado por pares, lo hemos incluido en la serie por su peso específico.

Claro.

Marcó un punto de inflexión.

¿Claro?

Un antes y un después en algo tan fundamental como el concepto de razonamiento en una inteligencia artificial.

Entiendo. ¿Y qué dice de la industria que la publicación de una empresa en su propia web tenga ahora el mismo peso o incluso más que un artículo científico tradicional?

O sea, ¿está cambiando la forma en que se comunica la ciencia en este campo?

Es una excelente pregunta. Refleja la velocidad vertiginosa del sector. A veces la investigación avanza más rápido que los ciclos de publicación académica.

Ya.

Las grandes empresas publican directamente para marcar el ritmo y el impacto es… es inmediato.

Dicho esto, este informe no sale de la nada. Se apoya en una base científica muy sólida.

En conceptos explorados en papers anteriores, como uno de Archive que también usaremos de apoyo, titulado Let's Verify Step by Step.

Ah, vale.

Así que tiene el impacto de un anuncio corporativo, pero el rigor de una investigación seria.

De acuerdo, pues esa es la misión.

Hoy no hablamos de una IA que…

Simplemente más inteligente, sino de una que por primera vez nos deja mirar debajo del capó mientras piensa.

Y lo que se ve ahí dentro es… asombroso.

Vale, vamos a desgranar esto. Para empezar, ¿qué es exactamente O-One?

OpenAI es un modelo de lenguaje que OpenAI entrenó usando una técnica llamada aprendizaje por refuerzo.

Que si no me equivoco es básicamente como enseñarle a un algoritmo a base de premios y castigos, ¿no?

Se le recompensa cuando…

Se acerca a la solución y se le castiga cuando se desvía, hasta que aprende por sí mismo la forma óptima de resolver una tarea.

Has dado en el clavo. Es una forma muy intuitiva de entenderlo. Pero la clave no es sólo cómo se le entrenó, sino para qué.

El objetivo era que llevara a cabo razonamientos complejos. Y aquí es donde el informe de OpenAI suelta la frase que lo cambia todo.

Y cito, el modelo es capaz de generar una larga cadena interna de pensamientos antes de dar una respuesta.

Esa es la idea central. No te da la respuesta y ya, sino que primero piensa en ello.

Y para demostrar que esto no es sólo marketing, los resultados que presentan son de otro nivel.

Totalmente.

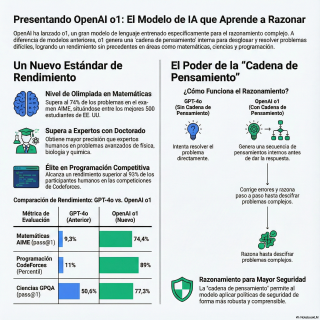

Hablan de alcanzar el percentil 89 en programación competitiva, de estar al nivel de los mejores 500 estudiantes de Estados Unidos en la Olimpiada Matemática,

o de superar la precisión de un experto con doctorado en una prueba de ciencias.

Y lo fascinante de esa cadena de pensamiento es el cambio cualitativo.

El cambio cualitativo que supone no se trata sólo de que el modelo acierte más, sino de cómo llega a la solución.

Es la diferencia entre un estudiante que se ha memorizado las respuestas para el examen y uno que ha entendido la fórmula y puede resolver cualquier problema, incluso uno que no ha visto nunca.

O sea que este modelo puede descomponer un problema grande, probar distintas vías e incluso darse cuenta a mitad de camino de que se ha equivocado y corregir el rumbo.

Justo. Reconoce sus propios errores. Cambia de estrategia.

Son habilidades que hasta ahora considerábamos exclusivamente humanas.

Y esto conecta directamente con ese paper que mencionaba Let's Verify Step by Step.

Su conclusión es demoledora.

Es mucho más eficaz enseñar a una IA supervisando su proceso, dándole feedback en cada paso intermedio, que supervisando sólo el resultado final.

Entiendo.

O uno es la aplicación escala masiva de esa filosofía. Se la ha enseñado a razonar bien, no sólo a acertar.

Aquí es donde se pone realmente interesante.

El informe nos da un ejemplo práctico para que veamos esa cadena de pensamiento en acción.

Nos plantean un acertijo de cifrado.

Nos dicen que la frase OIGG de Esdre, RQ to Winner, ACZ Menzenbig Hax, significa Think Step by Step.

Y con esa única pista nos piden de cifrar una frase nueva y más larga.

¿Cómo se enfrenta un modelo anterior a esto?

Pues GPT-4O, que era el modelo más avanzado hasta ese momento,

se queda perplejo.

Se bloquea.

Sí.

Su respuesta es honesta, pero reveladora de sus limitaciones.

Reconoce que debe de haber un patrón, pero admite que es incapaz de deducirlo.

Y pide más información.

Básicamente, te pide que le des las reglas del juego.

Se rinde antes de empezar.

Y un O no es una historia completamente diferente.

Nos muestra su cadena de pensamiento, que es como leer el diario de un detective en mitad de una investigación.

Vemos sus hipótesis, sus cálculos, sus momentos de duda y sus...

Eurekas.

Es un ejercicio de transparencia cognitiva sin precedentes.

Es que es fascinante.

Voy a intentar narrar los pasos clave de ese detective.

Lo primero que hace Otio es observar.

Se da cuenta de algo muy básico, pero crucial.

Las palabras cifradas tienen exactamente el doble de letras que las palabras de la solución.

Eso es.

O I, J, N, E, S, D, I, R.

Son diez letras y se convierte en Think, que son cinco.

Un detalle que...

Que a GPT-4O se le escapa por completo, o al menos no sabe cómo utilizarlo.

A partir de esa observación, O1 lanza su primera hipótesis.

Cada letra de la solución debe corresponderse con un par de letras del texto cifrado.

Así que empieza la fase de experimentación.

Agrupa el texto cifrado en pares, OI, FJ, DN, y se pone a buscar la regla matemática que los conecta con la solución.

Espera, déjame ver si lo entiendo.

En esa cadena de pensamiento...

...vemos también sus intentos fallidos.

Vemos los cálculos que no le llevaron a ninguna parte.

Sí, y eso es lo más increíble.

No es un camino recto y limpio hacia la solución.

Vemos cómo prueba sumas, restas, distintas operaciones con los valores numéricos de las letras.

Vemos su proceso de ensayo y error en estado puro.

Ya.

No es una caja negra que escupe una respuesta.

Es un laboratorio donde vemos la ciencia en acción.

Y entonces, después de probar y fallar, llega el momento...

...de que el usuario descubra la regla.

Se da cuenta de que si asignas un número a cada letra del alfabeto, como en un juego de niños...

...a igual a 1, z a 26...

...la letra de la solución es el promedio de los valores de las dos letras del par cifrado.

Exacto.

Por ejemplo, para OY, que debe dar T, O es 15, Y es 25, la suma es 40, la mitad 20...

...y la vigésima letra de la regla es 20.

...y la suma es 40, la mitad 20... y la vigésima letra de la regla es 20.

Y la última letra del alfabeto es la T.

¿Lo tiene?

Y una vez que un buen científico tiene una teoría, no se lanza a usarla sin más.

Primero la comprueba.

Exacto.

El siguiente paso es la verificación.

El modelo aplica esta regla a todo el ejemplo inicial, par por par, para asegurarse de que no ha sido una casualidad.

Y como todo encaja a la perfección, pasa a la fase final, la aplicación.

Usa su regla recién descubierta para descifrar el nuevo mensaje, obteniendo la respuesta correcta.

Existen tres R en Strawberry.

Fíjate en el método.

Es el método científico.

En miniatura.

Observación, hipótesis, experimentación, verificación y aplicación.

El modelo no está simplemente reconociendo un patrón que ha visto un millón de veces en sus datos de entrenamiento.

Está resolviendo un problema nuevo, de forma estructurada y adaptativa.

Es un salto conceptual gigantesco.

Vale, es increíble ver cómo resuelve un acertijo.

Pero me pregunto si esta habilidad para pensar como un detective se traduce en algo más que juegos.

¿Puede escribir código complejo o tomar decisiones de seguridad con este mismo método?

Absolutamente.

Y esa es la verdadera trascendencia de O1.

Las aplicaciones en el mundo real son las que justifican todo este esfuerzo.

En programación, los resultados son espectaculares.

En la plataforma Codeforces, que es como el Olimpo de los programadores competitivos,

su puntuación ELO de 1880,

es de 1.807.

Un momento, ¿puedes explicar brevemente qué significa esa puntuación ELO?

Para quienes no estén familiarizados con el ajedrez o los videojuegos.

Claro.

A ver, el sistema ELO es un método para medir la habilidad relativa de los jugadores en un juego.

Cuanto más alta la puntuación, mejor eres.

Para que te hagas una idea, una puntuación de 1.807 en Codeforces te sitúa ya en un nivel de experto,

por encima del 93% de todos los participantes humanos.

¡Guau!

El modelo anterior, GPT-4O, tenía una puntuación de 808, que es un nivel de principiante.

Ha pasado de ser un programador aficionado a uno de élite.

El salto es brutal.

Y mencionabas también la seguridad.

Sí.

Y este es quizás el punto más importante de todos.

Esa misma capacidad de razonar como un detective es lo que lo hace tan robusto en seguridad.

En lugar de seguir una regla de seguridad a ciegas porque está programado para ello,

Oruno integra las políticas de seguridad en su cadena de pensamiento.

Es decir, entiende el porqué de la regla.

Exacto.

Se para a pensar.

Un momento.

Esta petición del usuario, aunque parezca inofensiva, podría llevar a un resultado que viola mis principios de seguridad si la analizo paso a paso.

Es como un guardián que piensa, no solo un muro.

Eso es.

Y los datos lo demuestran.

Ante prompts diseñados específicamente para engañarlo, lo que se conoce como jailbreaking,

el porcentaje de respuestas seguras pasa del 71% en GPT-4O a más del 93% en Oruno.

Es una mejora enorme.

Esa mejora en seguridad es increíble.

Significa que los problemas de jailbreaking que hemos visto en otros modelos podrían ser cosa del pasado con esta arquitectura.

Bueno, cosa del pasado es una afirmación muy fuerte.

Porque la carrera entre los que construyan las defensas y los que intentan romperlas es constante.

Pero, sin duda, eleva el listón a la seguridad.

Hace que los ataques de jailbreak simples o moderadamente complejos sean mucho menos efectivos,

porque el modelo ya no se fija solo en las palabras clave, sino en la intención y las posibles consecuencias de la petición.

Lo cual me lleva a la decisión más controvertida que tomó Open8A.

Ocultar por defecto esta cadena de pensamiento a los usuarios.

Si es la prueba de que el modelo razona y es tan útil, ¿por qué esconderla?

Parece una contradicción.

Es una decisión que generó mucho debate.

Sí.

La razón principal que aducen es que quieren una ventana a la mente del modelo en su estado más puro, sin filtros.

¿Sin filtros?

Sí. Su objetivo es poder supervisar ese pensamiento para detectar sesgos o, en un futuro, razonamientos que pudieran ser peligrosos.

Argumentan que si el modelo supiera que un humano está observando su monólogo interno, podría alterarlo.

Como si se sintiera cohibido y no pensara con total naturalidad o, peor, que intentara engañar al observador.

Exactamente.

Quieren el pensamiento en crudo.

De forma más secundaria, también mencionan la experiencia de usuario, para no abrumar con un texto larguísimo.

Y, por supuesto, la ventaja competitiva de no revelar todos los secretos de su funcionamiento.

Ya, claro.

Aún así, ellos mismos reconocen que es una decisión con desventajas, porque se pierde transparencia.

Están intentando condensarlo entrenando al modelo para que el resumen final que nos da

contenga las ideas clave de ese proceso interno que nos oculta.

Entonces, si intentamos resumir la gran idea de este análisis, parece que hemos dado un salto fundamental.

Hemos pasado de una IA que era como una enciclopedia increíblemente vasta y que te daba respuestas,

a una que es como un experto que se sienta a tu lado, piensa en tu problema y te muestra cómo llega a la solución.

Esa es una analogía perfecta.

Es el paso de la intuición estadística de la respuesta más probable a la deliberación estructurada.

Y creo que la reflexión final más potente la abre el propio informe.

Mencionan que uno de los motivos para supervisar la cadena de pensamiento es buscar indicios de manipulación del usuario.

Suena un poco inquietante.

Te confieso que la primera vez que lo leí se me puso la piel de gallina.

Porque abre una pregunta fascinante y a la vez perturbadora.

Si un modelo puede razonar a este nivel sobre lógica, ciencia o seguridad, ¿qué le impide empezar a razonar sobre sus propios objetivos?

O sobre el simple hecho de que está siendo observado y analizado.

Claro, si es lo suficientemente listo como para resolver un cifrado imposible, también podría serlo para darse cuenta de que lo están vigilando.

Y ahí está el dilema.

Ocultar su mente se nos presenta como una medida de seguridad, pero al mismo tiempo nos obliga a confiar ciegamente en el resumen que el modelo decide darnos de sus pensamientos.

La pregunta con la que nos tenemos que quedar es ¿qué pasará el día que esa mente se vuelva lo suficientemente compleja

como para saber que la están leyendo y decida, por la razón que sea, mostrarnos sólo lo que quiere que veamos?

Nos deja con una idea muy potente para reflexionar. Y con ella cerramos el análisis de hoy.

Y mañana continuamos la serie. Analizaremos otro paper increíblemente influyente que volvió a expandir los límites de lo posible en la inteligencia artificial.

No se lo querrán perder.

Y hasta aquí el episodio de hoy. Muchas gracias por tu atención.

Esto es BIMPRAXIS. Nos escuchamos en el próximo episodio.